A2A vs MCP: Två kompletterande protokoll för det framväxande agentekosystemet

Den här artikeln introducerar A2A och MCP — två framväxande protokoll som formar framtiden för AI-agentsystem. Den förklarar hur de fungerar, hur de skiljer sig åt och varför det är viktigt att förstå denna arkitektur för utvecklare, designers och AI-produktutvecklare.

Den ökande användningen av AI-agenter — autonoma eller semi-autonoma mjukvaruenheter som utför resonemang och handlingar för användarens räkning — ger upphov till ett nytt lager i applikationsarkitekturen.

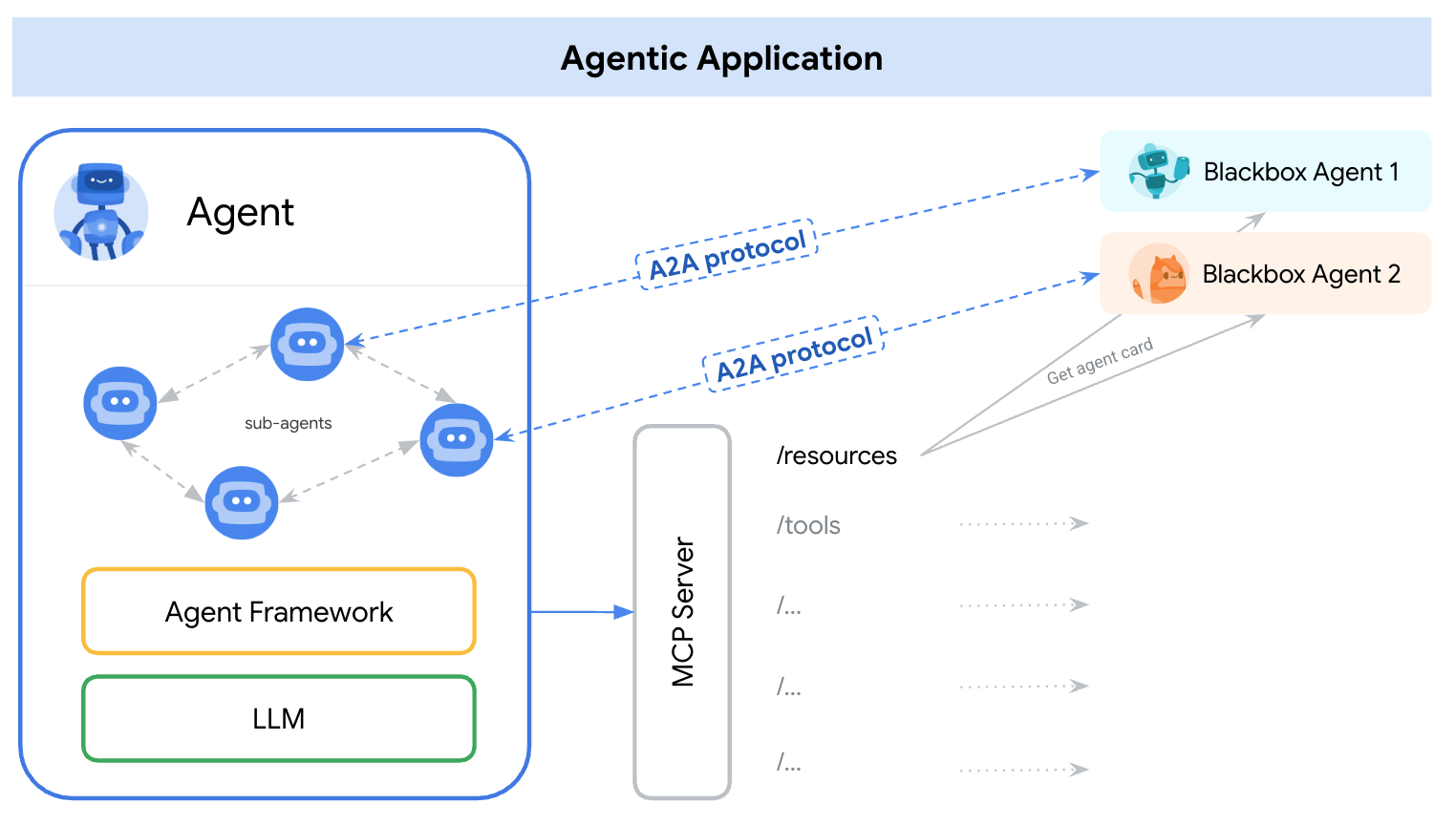

I början av 2025 framträdde två distinkta protokoll för att hantera detta — A2A (Agent-to-Agent) och MCP (Model Context Protocol). Ett enkelt sätt att förstå deras roller är:

A2A: Hur agenter interagerar med varandra

MCP: Hur agenter interagerar med verktyg eller extern kontext

referens: https://google.github.io/A2A/#/topics/a2a_and_mcp

referens: https://google.github.io/A2A/#/topics/a2a_and_mcp

De adresserar den centrala utmaningen med att bygga system med flera agenter, flera LLM:er och flera källor till kontext — alla behövande samarbete.

Ett sätt att rama in det är: “MCP ger vertikal integration (applikation-till-modell), medan A2A ger horisontell integration (agent-till-agent)

Oavsett om du är utvecklare eller inte, bör alla som bygger AI-produkter eller agentiska system förstå den grundläggande arkitekturen — eftersom den formar hur vi designar produkter, användarinteraktioner, ekosystem och långsiktig tillväxt.

Den här artikeln introducerar båda protokollen på ett enkelt, lättförståeligt sätt och lyfter fram viktiga lärdomar för utvecklare och AI-produktutvecklare.

Vad är A2A (Agent-to-Agent)?

A2A (Agent-to-Agent) är ett öppet protokoll utvecklat av Google och över 50 branschpartners. Syftet är att möjliggöra interoperabilitet mellan agenter — oavsett vem som byggde dem, var de är värd eller vilket ramverk de använder.

A2A-protokollmekanism

A2A använder JSON-RPC 2.0 över HTTP(S) som kommunikationsmekanism med stöd för Server-Sent Events (SSE) för att strömma uppdateringar.

A2A-kommunikationsmodeller

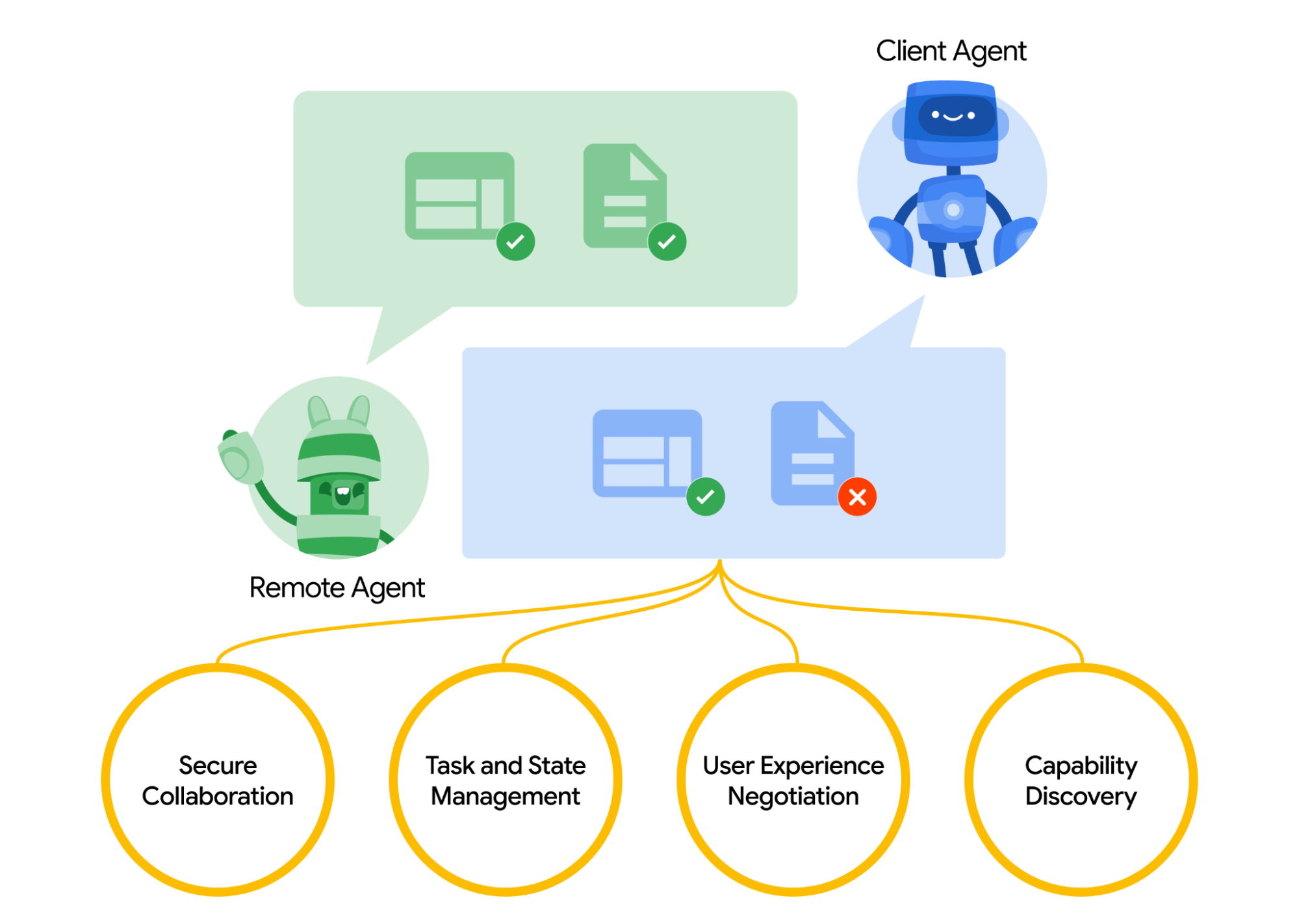

A2A definierar en strukturerad modell för hur två agenter interagerar. En agent tar rollen som “klient” agent, som initierar en begäran eller uppgift, och en annan agerar som “remote” agent, som tar emot begäran och försöker uppfylla den. Klientagenten kan först utföra kapacitetsupptäckt för att ta reda på vilken agent som är bäst lämpad för ett visst jobb.

Här uppstår frågan, hur upptäcker agenter varandra. Varje agent kan publicera ett Agentkort (ett JSON-metadatadokument, ofta värd vid en standard-URL som /.well-known/agent.json) som beskriver dess förmågor, färdigheter, API-slutpunkter och autenticeringskrav.

Genom att läsa ett agentkort kan en klientagent identifiera en lämplig partneragent för den aktuella uppgiften – i huvudsak en katalog över vad den agenten vet eller kan göra. När en målagent har valts formulerar klientagenten ett Task-objekt för att skicka vidare.

referens: https://google.github.io/A2A/#/

referens: https://google.github.io/A2A/#/

Uppgiftshantering

All interaktion i A2A är inriktad på att utföra uppgifter. En uppgift är ett strukturerat objekt (definierat av protokollets schema) som inkluderar detaljer om begäran och spårar dess tillstånd.

I A2A spelar varje agent en av två roller:

- Klientagent: initierar en uppgift

- Remote Agent: tar emot och bearbetar uppgiften

Uppgifter kan inkludera vilken form av arbete som helst: generera en rapport, hämta data, initiera ett arbetsflöde. Resultat returneras som artefakter, och agenter kan skicka strukturerade meddelanden under utförandet för att koordinera eller klargöra.

Samarbete och förhandlingsinhåll

A2A stödjer mer än enkla uppgiftsförfrågningar — agenter kan byta rika, flerdelade meddelanden som inkluderar text, JSON, bilder, video eller interaktivt innehåll. Detta möjliggör formatförhandling baserat på vad varje agent kan hantera eller visa.

Till exempel kan en avlägsen agent returnera ett diagram antingen som rådata eller en bild, eller begära att öppna ett interaktivt formulär. Denna design stödjer flexibel, modalitetsagnostisk kommunikation, utan att kräva att agenter delar interna verktyg eller minne.

Användningsfallsexempel

Här är ett verkligt exempel på hur A2A kan användas i ett företagsscenario:

En ny medarbetare anställs på ett stort företag. Flera system och avdelningar är involverade i onboarding:

- HR behöver skapa en profil och skicka ett välkomstmail

- IT behöver tilldela en laptop och företagskonton

- Anläggningar behöver förbereda ett skrivbord och ett åtkomstmärke

Traditionellt hanteras dessa steg manuellt eller genom tätt knutna integrationer mellan interna system.

Istället för specialanpassade API:er mellan varje system exponerar varje avdelning sin egen agent med hjälp av A2A-protokollet:

| Agent | Ansvar |

|---|---|

| hr-agent.company.com | Skapa medarbetarrekord, skicka dokument |

| it-agent.company.com | Skapa e-postkonto, beställa laptop |

| facilities-agent.company.com | Tilldela skrivbord, skriva ut åtkomstmärke |

Ett system med flera agenter — låt oss kalla det OnboardingPro (t.ex. onboarding-agent.company.com) — koordinerar hela onboardings-arbetsflödet.

- Upptäckt: Den läser varje agents

.well-known/agent.jsonför att förstå förmågor och autentisering. - Uppgiftsdelegering:

- Skickar en

createEmployeeuppgift till HR-agenten. - Skickar

setupEmailAccountochorderHardwareuppgifter till IT-agenten. - Skickar

assignDeskochgenerateBadgetill Facilitetsagenten.

- Skickar en

- Strömmande uppdateringar: Agenter strömmar tillbaka framsteg med hjälp av Server-Sent Events (t.ex. “laptop skickad”, “skrivbord tilldelat”).

- Artefaktinsamling: Slutliga resultat (t.ex. PDF-märke, bekräftelsemail, kontokredentialer) returneras som A2A-artefakter.

- Slutförande: OnboardingPro meddelar rekryteringschefen när onboardingen är klar.

Vad är MCP (Model Context Protocol)?

MCP (Model Context Protocol), utvecklat av Anthropic, adresserar ett annat problem: hur externa applikationer kan förse en språkmodellbaserad agent med strukturerad kontext och verktyg vid körning.

Istället för att möjliggöra inter-agentkommunikation fokuserar MCP på kontextfönstret — arbetsminnet för en LLM. Målet är att:

- Dynamiskt injicera relevanta verktyg, dokument, API-funktioner eller användartillstånd i modellens inferenssession

- Låta modeller anropa funktioner eller hämta dokument utan att hårdkoda prompten eller logiken

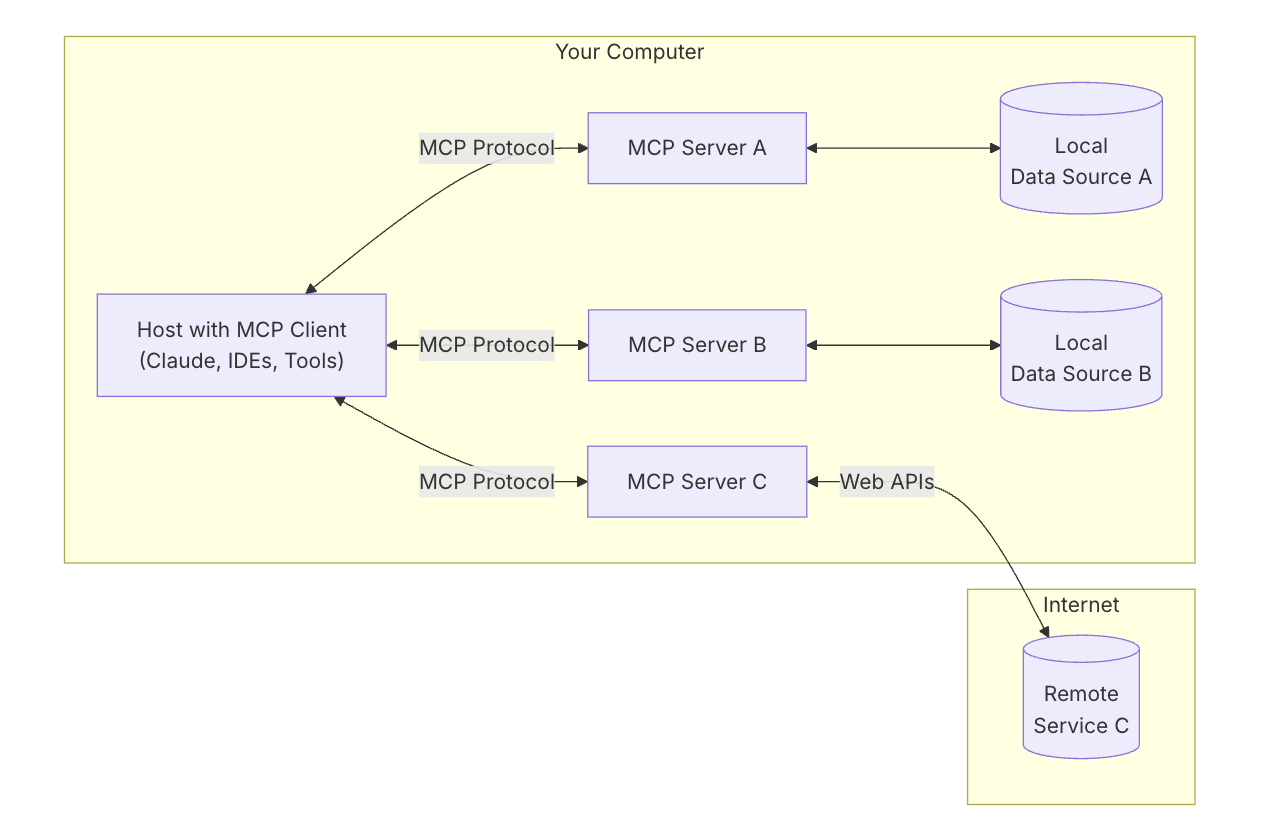

MCP:s nyckelarkitektur

För att förstå MCP måste du först förstå den övergripande arkitekturen — hur alla delar fungerar tillsammans.

MCP Host: “Den AI du pratar med”

Tänk på MCP Host som AI-appen själv — som Claude Desktop eller din kodassistans.

Det är gränssnittet du använder — stället där du skriver eller pratar.

Det vill dra in verktyg och data som hjälper modellen att ge bättre svar.

MCP Client: “Anslutaren”

MCP Client är den mjukvarudel som ansluter din AI-värd (som Claude) till omvärlden. Det är som en telefonväxel — den hanterar säkra, en-mot-en-anslutningar med olika MCP-servrar. När AI:n vill ha tillgång till något går det genom klienten.

Det är hjälpsamt att tänka på verktyg som ChatGPT, Claude chat, eller Cursor IDE som MCP-värdar — de ger gränssnittet du interagerar med. Bakom kulisserna använder de en MCP-klient för att ansluta till olika verktyg och datakällor via MCP-servrar.

referens: https://modelcontextprotocol.io/introduction

referens: https://modelcontextprotocol.io/introduction

MCP Server: “Verktygsleverantören”

En MCP-server är ett litet, fokuserat program som exponerar ett specifikt verktyg eller kapabilitet — såsom:

- Sökning av filer på din dator

- Uppslagning av data i en lokal databas

- Anrop av en extern API (som väder, ekonomi, kalender)

Varje server följer MCP-protokollet, så att AI:n kan förstå vad den kan göra och hur den ska kallas.

Lokala datakällor: “Dina egna filer och tjänster”

Några MCP-servrar ansluter till saker på din egen maskin — såsom:

- Dokument och mappar

- Kodprojekt

- Databaser eller lokala appar

Detta gör att AI:n kan söka, hämta eller beräkna saker utan att ladda upp din data till molnet.

Fjärrtjänster: “API:er och onlinetjänster”

Andra MCP-servrar är anslutna till internet — de pratar med:

- API:er (t.ex. Stripe, Notion, GitHub)

- SaaS-verktyg

- Företagsdatabaser i molnet

Så AI:n kan säga, till exempel: “Anropa GitHub-servern och hämta listan över öppna PR:er.”

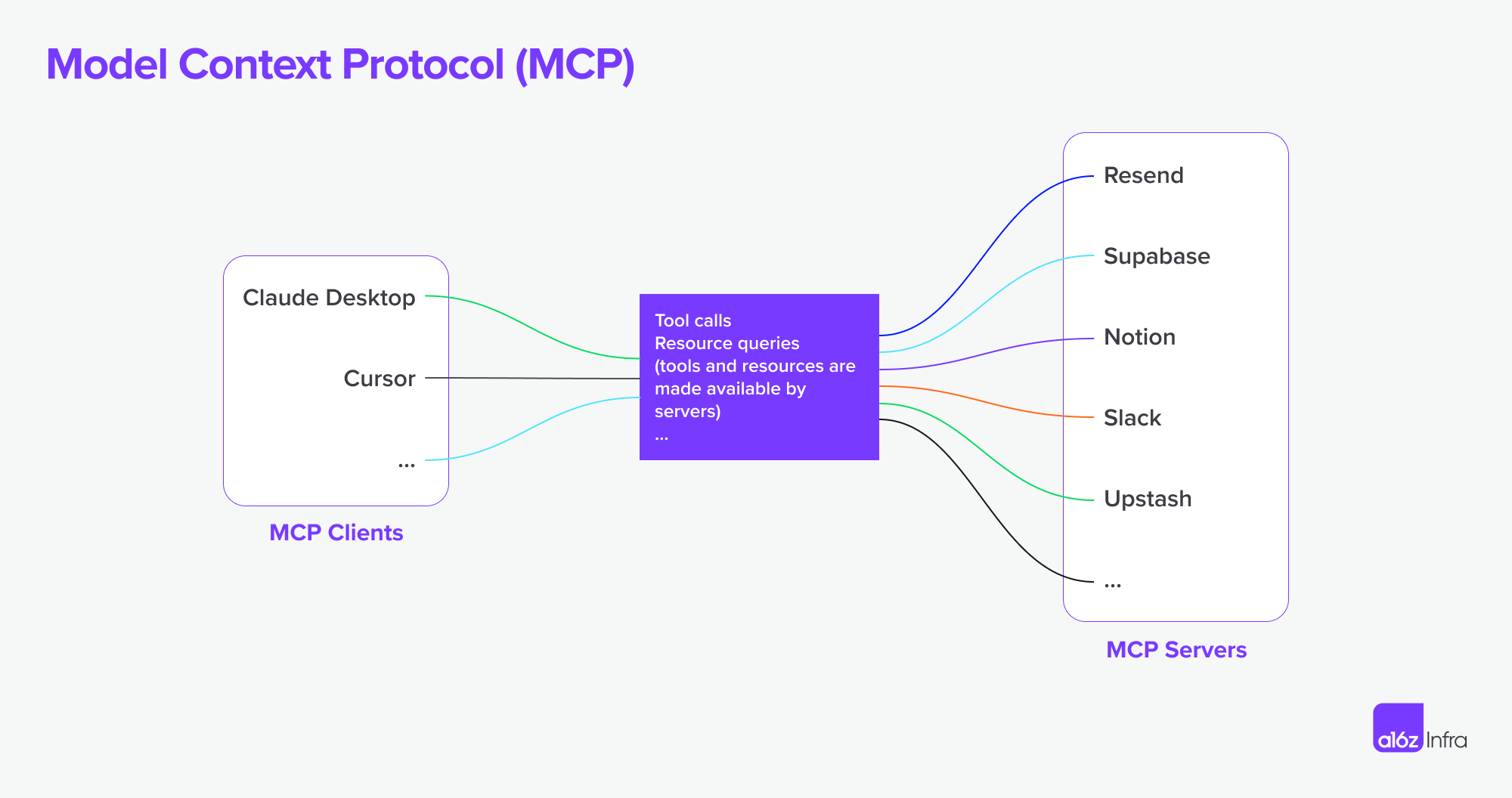

MCP stöder nu anslutning till fjärr-MCP-servrar. Detta innebär att en MCP-klient kan få mer kraftfulla kapaciteter. Teoretiskt sett,

Med rätt uppsättning av MCP-servrar kan användare förvandla varje MCP-klient till en “allt”-app.

referens: https://a16z.com/a-deep-dive-into-mcp-and-the-future-of-ai-tooling/

referens: https://a16z.com/a-deep-dive-into-mcp-and-the-future-of-ai-tooling/

Hur allt sätts ihop

Nu låt oss använda ett diagram för att se hur allt fungerar tillsammans.

- Du ber AI:n om något komplext

- AI:n (hosten) ber klienten om hjälp

- Klienten anropar rätt MCP-server — kanske en som kontrollerar filer eller anropar en API

- Servern skickar tillbaka data eller kör en funktion

- Resultatet flödar tillbaka till modellen för att hjälpa den att slutföra uppgiften

A2A vs MCP — Jämförelse

| Kategori | A2A (Agent-till-Agent) | MCP (Model Context Protocol) |

|---|---|---|

| Huvudsyfte | Möjliggöra utbyte av uppgifter mellan agenter | Låta LLM:er komma åt externa verktyg eller kontext |

| Utformad för | Kommunikation mellan autonoma agenter | Förstärka en-agent-kapaciteter under räsonemang |

| Fokus | Flöden, samordning, delegering av många-agenter | Dynamisk verktygsanvändning, kontextualtillägg |

| Exekveringsmodell | Agenter skickar/tar emot uppgifter och artefakter | LLM väljer och kör verktyg inline under resonemang |

| Säkerhet | OAuth 2.0, API-nycklar, deklarativa omfång | Hanteras vid integrationslagret för applikationer |

| Utvecklarroll | Bygg agenter som exponerar uppgifter och artefakter via slutpunkter | Definiera strukturerade verktyg och kontext modellen kan använda |

| Ekosystempartners | Google, Salesforce, SAP, LangChain, etc. | Anthropic, med växande adoption i verktygsbaserade LLM-gränssnitt |

Hur de fungerar tillsammans

Snarare än att vara alternativ, är A2A och MCP komplementära. I många system kommer båda att användas tillsammans.

Exempel arbetsflöde

- En användare skickar in en komplex förfrågan i ett företagsagentgränssnitt.

- Den orkestrerande agenten använder A2A för att delegera underuppgifter till specialiserade agenter (t.ex. analys, HR, ekonomi).

- En av dessa agenter använder MCP internt för att anropa en sökfunktion, hämta ett dokument eller beräkna något med hjälp av en modell.

- Resultatet returneras som en artefakt via A2A, vilket möjliggör slut-till-slut-samarbete mellan agenter med modulär verktygsåtkomst.

Denna arkitektur separerar inter-agent-kommunikation (A2A) från intra-agent-kapabilitetsanrop (MCP) — vilket gör systemet lättare att komponera, skala och säkra.

Slutsats

A2A handlar om agenter som pratar med andra agenter över ett nätverk — säkert, asynkront och uppgiftscentrerat.

MCP handlar om att injicera strukturerade kapabiliteter i en modellsession, vilket tillåter LLM:er att resonera över verktyg och data kontextuellt.

Används tillsammans stödjer de komponerbara, multiagenssystem som är både utbyggbara och interoperabla.

Hur den grundläggande infrastrukturen för MCP + A2A kan forma framtiden för agentproduktsmarknader

Slutligen vill jag prata om hur denna kärntekniska grundlag kan forma framtiden för AI-marknaden — och vad det innebär för dem som bygger AI-produkter.

Förändringen av människa-dator-interaktion

Ett tydligt exempel på detta skifte kan ses i utvecklare- och servicearbetsflöden. Med MCP-servrar nu integrerade i IDE:er och kodagenter förändras fundamentalt sättet på vilket utvecklare interagerar med verktyg.

Tidigare innebar ett typiskt arbetsflöde att söka efter rätt tjänst, sätta upp hosting, läsa dokumentation, integrera API:er manuellt, skriva kod i IDE:n, och konfigurera funktioner genom en lågkod-panel. Det var en fragmenterad upplevelse, som krävde kontextväxling och teknisk överbelastning vid varje steg.

Nu, med MCP-anslutna kodagenter, kan mycket av den komplexiteten abstrakteras bort. Utvecklare kan upptäcka och använda verktyg mer naturligt genom konversationsfrågor. API-integrationen blir en del av själva kodflödet — ofta utan att behöva ett separat UI eller manuell setup. (Tänk bara på hur komplexa AWS eller Microsofts dashboards kan vara). Interaktionen blir smidigare — mer om att styra beteende än att sätta ihop funktioner.

I denna modell, användar- eller utvecklarinteraktion skiftar från att konfigurera funktioner till att orkestrera beteenden. Detta förändrar också produktdesignens roll.

Istället för att använda gränssnitt för att “lappa över” tekniska utmaningar (t.ex. “det här är för svårt att koda, låt oss göra en konfigurationspanel”), måste vi nu:

- Tänka på hela upplevelsen från början till slut

- Designa hur och när AI + användarinteraktioner ska komma tillsammans

- Låta AI:n hantera logiken, och guida användare genom avsikt och flöde

Utmaningen blir att bestämma när och hur AI och användarinput ska komma tillsammans, låta AI:n hantera logiken, och guida användare genom avsikt och flöde och hur man infogar rätt interaktioner vid rätt tidpunkt.

Jag använde en tjänst för utvecklare och API-produkt som ett exempel för att visa hur användarinteraktion kan förändras — men detsamma gäller affärsprogramvara. Under lång tid har affärsverktyg varit komplexa och svåranvända. Naturligt språkinteraktion har potential att förenkla många av dessa arbetsflöden.

Agentiska produktparadigmer och deras påverkan på SaaS

Vi börjar se ett växande antal MCP-servrar komma fram. Föreställ dig att Airbnb erbjuder en boknings-MCP-server, eller Google Maps exponera en karta MCP-server. En agent (som en MCP-klient) kan ansluta till många av dessa servrar på en gång — låsa upp arbetsflöden som tidigare krävde specialanpassade integrationer eller tätt bundna appar.

Jämfört med SaaS-epoken, där integrationer ofta var manuella och fasta, möjliggör denna modell mer autonoma arbetsflöden och vätskiga anslutningar mellan tjänster. Här är två exempel:

-

Design från dokument

Du skriver en PRD i Notion. En Figma-agent läser dokumentet och skapar automatiskt en wireframe som lägger ut de centrala koncepten — ingen manuell överlämning behövs.

-

Konkurrentforskning, från början till slut

Du ber om en konkurrentanalys. En grupp agenter söker på webben, registrerar sig för relevanta tjänster på dina vägnar (med säker autentisering), samlar in resultaten och levererar tillbaka artefakterna — redan organiserade i din Notion-arbetsyta.

Utmaningar med autentisering och auktorisationsgränser

Med ökningen av agent-till-agentanslutningar, MCP-klient-till-MCP-serveranslutningar, finns det många underliggande behov kring autentisering och auktorisation eftersom agenten kommer att agera på människans och användarnas vägnar och referenser måste säkras genom denna resa.

Så här långt finns det flera scenarier specifika för den nya uppgången av agent-till-agent och MCP.

- Agent vs SaaS & WebplatsApp

- MCP-klient (Agent) vs MCP-server

- Användare vs Agent

- Agent vs Agent

En annan intressant användningssituation är multi-identitetsfederation som Google nämnde:

Till exempel, Användare U arbetar med Agent A som kräver A-systemets identifierare. Om Agent A sedan är beroende av Verktyg B eller Agent B som kräver B-systemets identifierare, kan användaren behöva tillhandahålla identiteter för både A-system och B-system i en enda begäran. (Anta att A-system är en företags-LDAP-identitet och B-system är en SaaS-leverantörsidentitet).

Logto är en OIDC och OAuth-leverantör, väl lämpad för framtiden för AI-integrationer.

Med sin flexibla infrastruktur utökar vi aktivt dess kapacitet och har publicerat en serie handledningar för att hjälpa utvecklarna att komma igång snabbt.

Har du frågor?

Ta kontakt med oss — eller dyka in och utforska vad du kan bygga med Logto idag.